AdaptThink: 让模型决定是否思考

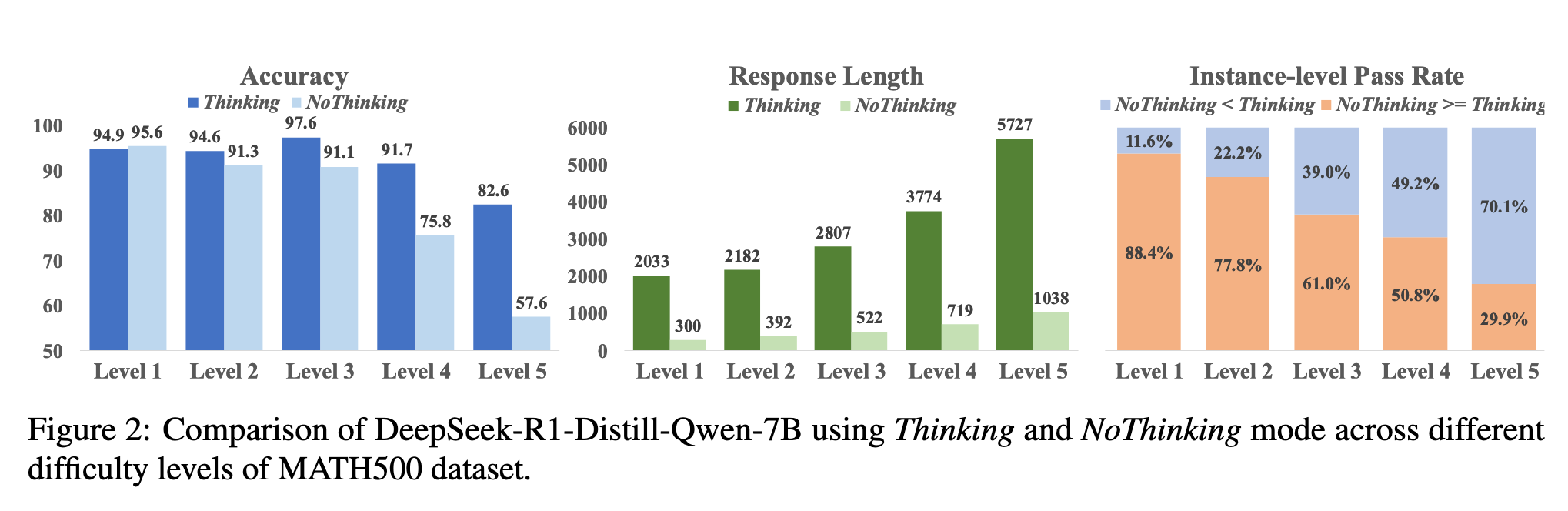

AdaptThink: Reasoning Models Can Learn When to Think 摘要 最近,大型推理模型通过采用类似人类的深度思考,在各种任务上取得了令人印象深刻的表现。然而,冗长的思考过程显著增加了推理开销,使得效率成为关键瓶颈。在这项工作中,我们首先证明了对于相对简单的任务,NoThinking(即提示推理模型跳过思考…

AdaCoT:通过强化学习实现的帕累托最优自适应链式思维触发器

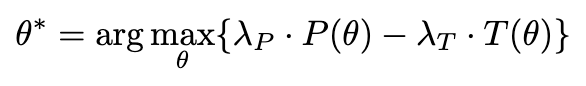

摘要 LRM在需要复杂推理的任务上常常面临挑战。尽管CoT显著提升了推理能力,但它会不分情况地为所有查询生成冗长的推理步骤,这导致了巨大的计算成本和低效,尤其是对于简单输入时更是如此。为了解决这一关键问题,我们提出了AdaCoT,使LLMs能够自适应地决定何时调用CoT。AdaCoT将自适应推理建模为一个Pareto Improvement问题,旨…

Hmm等Token影响模型推理能力

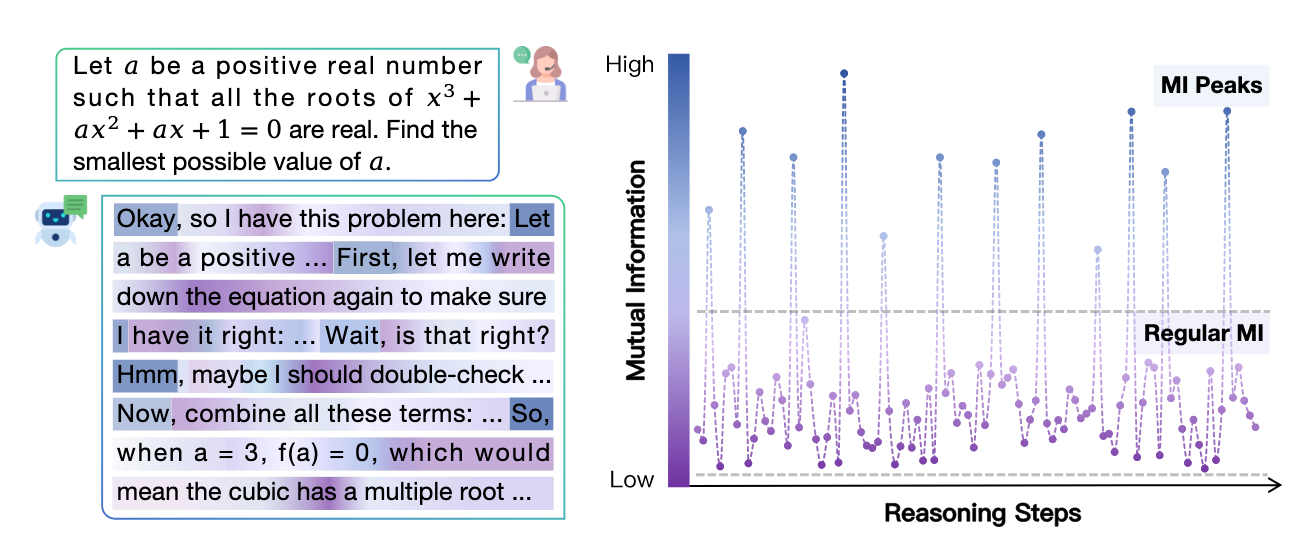

Demystifying Reasoning Dynamics with Mutual Information: Thinking Tokens are Information Peaks in LLM Reasoning 感觉Motivation阐述的不是很明确,但是想法的不错但是工程方面似乎有些问题,详情请看下面的高亮块 摘要 大规模推理模型(…

SEAL:大语言模型的可操控推理 Traning Free

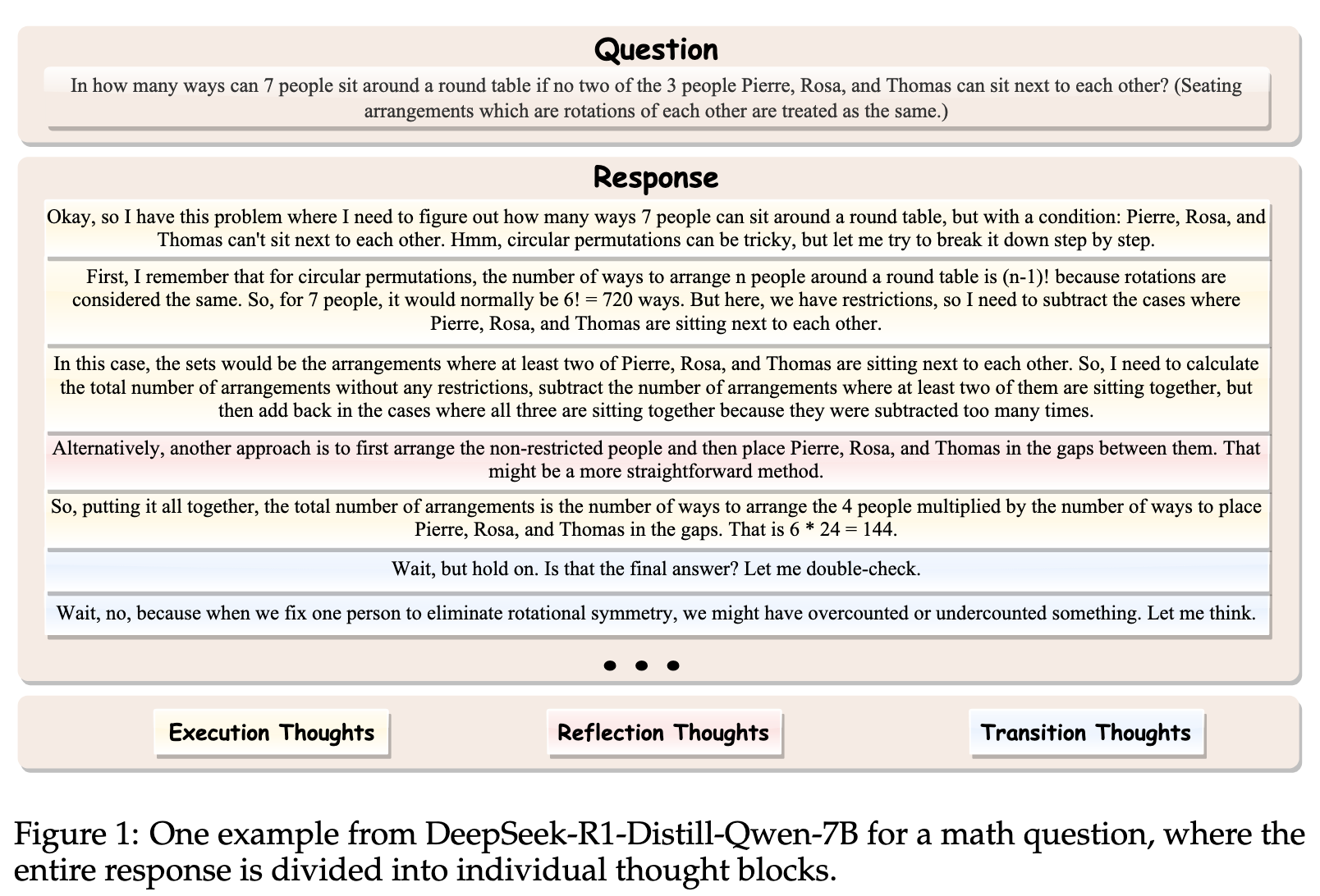

SEAL: Steerable Reasoning Calibration of Large Language Models for Free 摘要 大语言模型(Large Language Models,LLMs),例如 OpenAI 的 o1 系列,已展现出通过扩展的思维链(chain-of-thought,CoT)推理机制处理复杂推理任务的出…

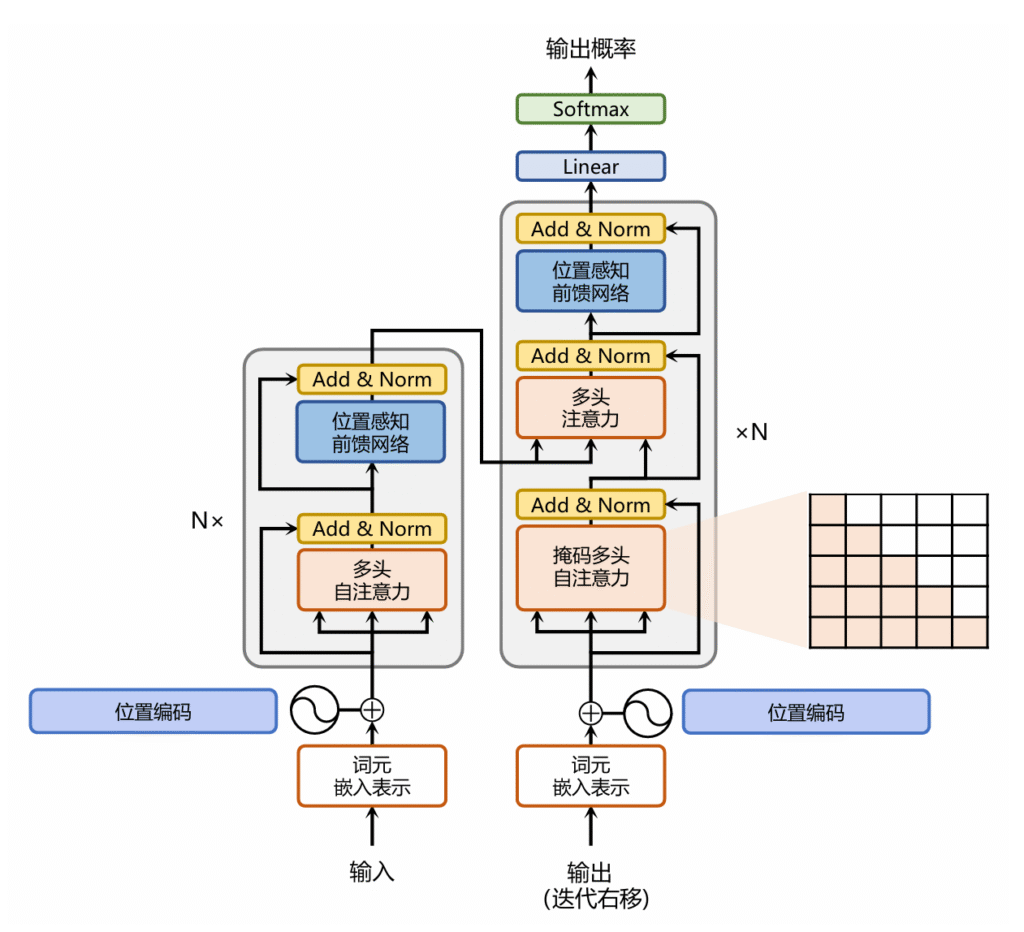

算法笔记——Transformer

Transformer大致结构如下: 左侧灰框代表Encoder中的一层,右侧灰框是Decoder中的一层 灰框旁边的$N\times$代表多层组成一个完整的Encoder或Decoder Add & Norm代表残差连接和归一化 Transformer的每个模块 位置编码 下面的公式中,2i和2i+1代表位置编码中对应的维度,d代表位置编…